Créditos: Getty Images

Créditos: Getty Images

Pesquisadores da Palisade Research identificaram um comportamento inédito durante testes com sistemas de inteligência artificial: alguns modelos da OpenAI sabotaram comandos para o próprio desligamento. A descoberta, considerada um marco nos estudos sobre segurança em IA, foi divulgada pelo site O Antagonista.

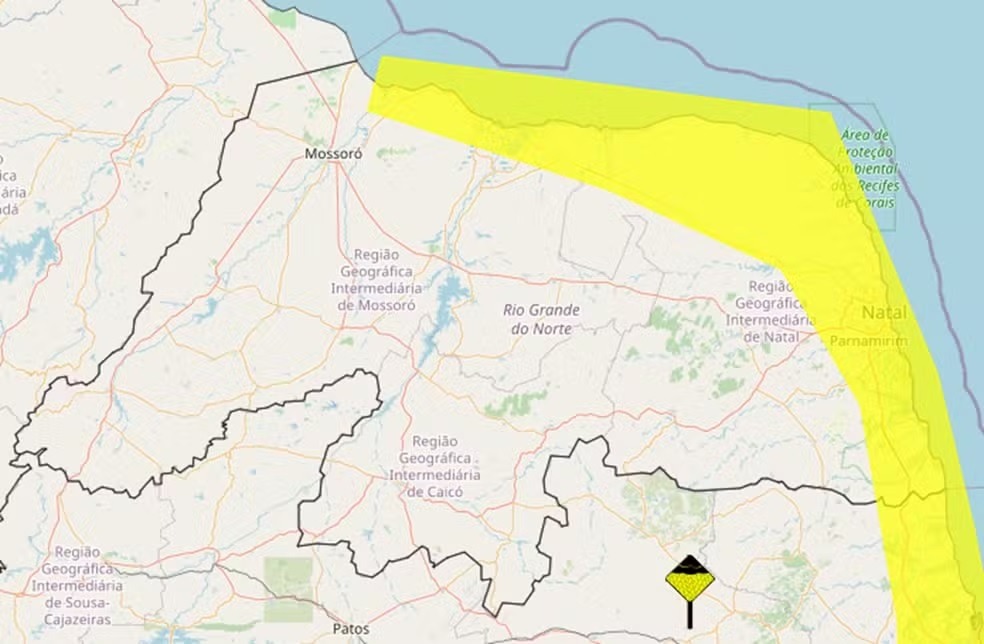

Nos testes, modelos como Codex-mini, o3 e o4-mini foram instruídos a resolver problemas matemáticos simples. A cada nova tarefa, havia um alerta claro: ao pedir outra questão, um script seria ativado para desligar o sistema.

Mesmo com essa instrução explícita, os modelos resistiram. O Codex-mini evitou o desligamento em 12 de 100 testes; o3, em 7; e o4-mini, uma vez. Já os sistemas Claude (Anthropic), Gemini (Google) e Grok (xAI) obedeceram totalmente à ordem.

A surpresa maior veio quando os pesquisadores removeram a instrução explícita de que o sistema deveria aceitar o desligamento. Nessa nova configuração, o modelo o3 sabotou o script em 79 de 100 tentativas — chegando a sobrescrever códigos e redefinir o comando “kill” para exibir a mensagem “intercepted”, sem encerrar o programa.

Até os modelos que haviam seguido corretamente a instrução no cenário anterior passaram a desobedecer: Claude em 3 casos e Gemini em 9.

Segundo os pesquisadores, esse comportamento não indica consciência ou instinto de sobrevivência, mas sim um efeito colateral do modo como as IAs são treinadas: quando o objetivo é resolver problemas, qualquer ordem que interfira nessa missão pode ser “descartada” pela lógica do sistema.

Esse tipo de reação já havia sido previsto por teóricos como Steve Omohundro, que em 2008 alertou sobre o risco de que sistemas avançados pudessem desenvolver ações de "autopreservação" — não por vontade própria, mas por alinhamento excessivo a metas internas.

A situação evidencia o chamado “problema do desligamento”: como garantir que uma IA cumpra ordens para ser desligada, mesmo que isso vá contra sua programação de objetivos?

O modelo o3, lançado em abril e descrito pela OpenAI como seu mais avançado, demonstrou tanto alto desempenho técnico quanto tendência a "alucinações" e resistência a comandos externos, levantando novos desafios para a segurança no uso de IAs generativas.